Cybersécurité, cadre juridique, consommation énergétique, pénurie de talents, compétitivité économique : autant de défis que les entreprises technologiques doivent relever pour exploiter pleinement le potentiel de l’intelligence artificielle et anticiper ses enjeux.

Qui est responsable lorsqu’un algorithme autonome commet une erreur aux conséquences lourdes ? Comment protéger les données sensibles, renforcer la conformité réglementaire et respecter l’IA Act ? Quels risques posent les déséquilibres croissants des investissements entre l’Europe et les États-Unis dans la course à l’innovation IA ?

75%

C’est la part des dirigeants qui considèrent l’intelligence artificielle comme l’une des trois priorités stratégiques.

Cybersécurité et conformité : comment protéger les données sensibles de l’IA ?

Les entreprises tech manipulent des volumes croissants de données sensibles, souvent nécessaires au bon fonctionnement des algorithmes d’IA. Cette dépendance accrue expose les organisations à des risques exponentiels de cyberattaques, de violations de données ou d’altérations malveillantes. L’impact et les conséquences d’une cyberattaque sur l’entreprise est d’autant plus considérable que les données sont sensibles.

💡 Un exemple marquant est celui d’une startup de la santé numérique (Metech) qui a subi une fuite massive de données en 2024. Les hackers ont exploité des failles dans les protocoles de transfert des données entre capteurs et serveurs. Les conséquences : des pertes financières importantes avec le blocage de l’activité, des procédures juridiques intentées par les parties prenantes et une perte de confiance des clients.

Les enjeux pour les entreprises tech dans l’utilisation de l’IA et la sécurisation des données sont notamment :

- Renforcer les protocoles de cryptage pour protéger les données en transit.

- Déployer des solutions de détection des anomalies en temps réel.

- Investir dans des audits réguliers pour vérifier la robustesse des infrastructures IT.

- Souscrire à une assurance cyber risque pour limiter les conséquences financières.

Les réglementations autour de l’IA évoluent rapidement. En Europe, l’IA Act impose des obligations strictes pour garantir la transparence et la sécurité des systèmes IA, notamment pour ceux classifiés comme « à haut risque ». Le non-respect de ces normes expose les entreprises à des sanctions financières et à des restrictions de marché. La mise en conformité avec le RGPD et l’IA Act devient une étape incontournable pour garantir une intégration sécurisée et légale.

Nous identifions 3 bonnes pratiques à intégrer dans votre entreprise :

Mobiliser votre équipe juridique dans la veille réglementaire pour anticiper les évolutions.

Documenter les processus de développement IA pour répondre aux exigences d’audit.

Collaborer avec des experts spécialisés en conformité IA.

IA et responsabilité juridique : à qui revient la faute ?

En 2025, l’essor des algorithmes d’IA soulève des questions complexes sur la responsabilité juridique. Qui doit répondre des conséquences lorsque ces systèmes prennent des décisions autonomes ? Le développeur de l’algorithme, l’entreprise qui l’utilise, ou même l’utilisateur final ?

Ces interrogations deviennent particulièrement critiques lorsque des erreurs entraînent des dommages financiers, éthiques ou même physiques.

Imaginons une plateforme de recrutement qui repose sur un algorithme d’intelligence artificielle pour trier les candidatures. Si cet outil écarte systématiquement certains profils en raison d’un biais algorithmique, cela peut entraîner des accusations de discrimination. Les candidats rejetés pourraient se retourner contre l’entreprise, mais aussi contre le développeur qui a conçu le modèle. Ce type de situation met en lumière la difficulté de déterminer à qui incombe la faute : l’entreprise qui utilise l’outil sans vérification approfondie ou le concepteur qui n’a pas anticipé les biais ?

Ces dilemmes juridiques soulignent l’importance d’instaurer des garde-fous dès la conception des systèmes. La transparence dans les décisions prises par les algorithmes, les audits réguliers pour détecter les biais et les clauses contractuelles définissant clairement les responsabilités deviennent indispensables pour éviter les litiges.

L’IA Act et la responsabilité juridique

L’IA Act impose des règles strictes en matière de transparence, sécurité et traçabilité pour les intelligences artificielles « à haut risque » et impose des sanctions en cas de non-conformité. Il encadre les biais algorithmiques et interdit certaines pratiques dangereuses, mais ne tranche pas clairement la question de la responsabilité en cas d’erreur.

– Qui est responsable lorsqu’un algorithme prend une décision erronée ?

– Quels recours pour les victimes d’une IA discriminante ou d’une erreur ?

Si l’IA Act établit un cadre, il ne résout pas totalement ces enjeux. D’où l’importance d’adopter des clauses contractuelles solides, des audits réguliers et une assurance adaptée. 🔗 Découvrir l’explorateur de la loi sur l’IA

Cependant, ces mesures ne suffisent pas toujours à combler le vide juridique laissé par la rapidité des avancées technologiques et les tendances de développement de l’intelligence artificielle, souvent plus rapides que l’évolution des lois.

Cette question de la responsabilité n’est pas seulement une problématique juridique. Elle reflète aussi une préoccupation éthique plus large : comment garantir que les systèmes d’IA, de plus en plus intégrés dans nos vies, respectent les principes fondamentaux d’équité et de non-discrimination ? Les entreprises qui déploient ces technologies ont la responsabilité de s’assurer que leurs outils n’aggravent pas les inégalités ou ne portent pas atteinte aux droits des individus.

Face aux défis que soulève l’IA, la question de l’assurance devient centrale.

- Pourquoi ? L’assurance accompagne cette transformation en protégeant à la fois l’innovation et la responsabilité des entreprises.

- Comment ? En offrant des garanties spécifiques pour sécuriser les données, anticiper les litiges et assurer la conformité des systèmes.

Protégez votre innovation et sécurisez votre avenir avec une assurance adaptée l’utilisation de l’intelligence artificielle.

L’impact environnemental de l’intelligence artificielle

En 2024, l’essor des technologies d’IA a entraîné une augmentation notable de la consommation énergétique. Pour 2025, cette évolution génère des préoccupations environnementales majeures.

Les centres de données, indispensables au fonctionnement des algorithmes d’IA, consomment des quantités massives d’électricité. En 2023, les émissions de CO₂ de Google ont grimpé de 13 %, atteignant 14,3 millions de tonnes. Cette hausse résulte principalement de l’intensification de la demande énergétique de ses centres de données.

La consommation énergétique des modèles d’IA découle de l’entraînement et de l’exécution de modèles complexes qui nécessitent une puissance de calcul colossale.

4,5%

Selon certaines projections, c’est la part de la consommation énergétique que l’IA pourrait représenter d’ici à 2030.

Pour faire face à ces défis, les entreprises technologiques testent différentes solutions afin de limiter l’empreinte carbone de l’IA. Certaines misent sur les énergies renouvelables pour alimenter leurs centres de données. D’autres conçoivent des algorithmes moins énergivores. Google, par exemple, ajuste en temps réel la consommation énergétique de ses centres de données grâce à l’IA, ce qui réduit considérablement leur impact environnemental.

Ces initiatives, bien qu’encourageantes, restent insuffisantes pour répondre aux objectifs climatiques globaux. Les entreprises doivent prendre des mesures plus ambitieuses pour limiter l’impact écologique de l’IA.

Intégrer des considérations de durabilité dès la conception des technologies devient une priorité pour aligner innovation et responsabilité environnementale.

Le défi du recrutement et de la rétention des talents

450%

L’évolution du nombre d’offres d’emploi hebdomadaires liées à l’intelligence artificielle générative.

🔗 Étude de la plateforme américaine de travail en freelance Upwork.

En 2025, la demande pour des experts en intelligence artificielle (IA) atteindra des sommets. Elle va créer une compétition féroce entre les entreprises pour attirer et retenir ces talents précieux. Selon une étude récente, 25 % des entreprises prévoient de créer des postes en CDI, principalement pour des experts en IA et en sécurité, tandis que 48 % comptent maintenir leurs effectifs actuels.

Cette pénurie de spécialistes en IA freine l’innovation et la compétitivité des entreprises. Les profils recherchés, tels que les data scientists, les ingénieurs en Machine Learning et les spécialistes en traitement des modèles de langage, sont rares et très sollicités. Les entreprises doivent donc redoubler d’efforts pour attirer ces talents : proposer des rémunérations attractives, des opportunités de développement professionnel et une culture d’entreprise stimulante.

Pour pallier cette pénurie, certaines organisations investissent dans la formation interne, développent des partenariats avec des institutions académiques ou misent sur la mobilité internationale. Cependant, ces stratégies nécessitent du temps et des ressources et ne garantissent pas toujours le succès face à une demande croissante et à une offre limitée.

Ainsi, le recrutement et la rétention des talents en IA demeurent des défis majeurs pour les entreprises en 2025 en nécessitant des approches innovantes et proactives pour assurer leur compétitivité sur le marché.

💡 L’œil de l’expert : boostez l’attractivité de votre entreprise et la fidélisation de vos salariés avec une mutuelle et prévoyance adaptée aux besoins de vos employés et leur famille.

Financer l’intelligence artificielle : un enjeu stratégique et politique

En 2025, les États-Unis amplifient leurs investissements dans l’intelligence artificielle. Le gouvernement fédéral déploie un plan de 500 milliards de dollars, destiné à moderniser les infrastructures numériques et à construire des centres de données de nouvelle génération. Ce projet, nommé « Stargate », inclut des initiatives stratégiques pour renforcer la souveraineté technologique du pays.

Parallèlement, les entreprises privées continuent d’injecter des milliards dans le développement de l’IA, avec des acteurs comme OpenAI ou Anthropic, qui reçoivent des financements record de Microsoft et Amazon.

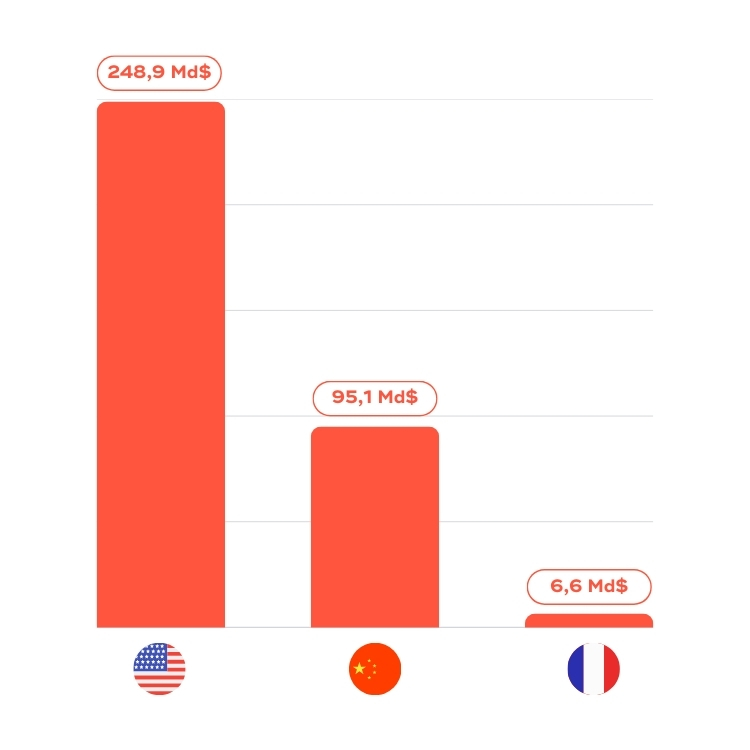

Les investissements privés dans l’IA (2013-2022) en milliards de dollars

(Source : Étude de Statista)

L’Europe reste en retrait par rapport aux États-Unis. En 2024, les investissements européens en IA atteignent à peine la moitié de ceux des Américains. Ce retard limite les capacités des entreprises européennes à adopter l’IA à grande échelle.

Face à cette offensive américaine, l’Europe accélère ses efforts pour rester compétitive. En 2024, l’Union européenne lance le « plan coordonné sur l’intelligence artificielle », visant à harmoniser les stratégies nationales et à accroître les investissements publics et privés. Bien que l’écosystème européen progresse, les disparités persistent. Les start-up européennes peinent à rivaliser avec leurs homologues américaines, qui accèdent à des financements plus élevés et plus rapides.

Pour combler cet écart, plusieurs initiatives émergent, comme la proposition d’une agence européenne inspirée de la DARPA américaine (Defense Advanced Research Projects Agency). L’objectif consiste à financer les projets technologiques de rupture et à positionner l’Europe comme un leader dans le domaine de l’IA. Pour répondre à ces défis, l’Europe mise sur des partenariats publics-privés et sur des financements plus ambitieux. Cependant, l’efficacité de ces initiatives dépendra de leur rapidité d’exécution et de leur capacité à rivaliser avec les stratégies américaines.

💡 Après des levées de fonds records en 2024 pour l’intelligence artificielle, en 2025, nous pouvons nous attendre à une nette accélération des levées de fonds dans ce secteur.

Un défi supplémentaire pour les entreprises tech où il est essentiel de bien préparer ses assurances lors de la levée de fonds pour accompagner sa croissance rapide.

Malgré cette compétition, les États-Unis et l’Europe trouvent des terrains de coopération. Des alliances transatlantiques naissent pour utiliser l’IA dans des projets de recherche communs, notamment dans la lutte contre le changement climatique ou l’amélioration des soins de santé. Par ailleurs, les deux régions prennent des mesures pour encadrer l’utilisation de l’IA.

Aux États-Unis, un décret signé par le président impose aux entreprises de partager leurs tests de sécurité pour les IA présentant des risques élevés. En Europe, l’IA Act continue de structurer le cadre légal, astreignant des obligations strictes en matière de transparence et de sécurité des systèmes.