L’intelligence artificielle est utilisée par toutes vos équipes. Parfois sans que vous ne le sachiez.

- Un collaborateur envoie un fichier confidentiel dans ChatGPT.

- Un développeur copie-colle du code généré automatiquement dans un produit en production.

- Un stagiaire crée un post LinkedIn à l’aide d’un prompt mal rédigé contenant des données internes.

Chaque jour, sans gouvernance claire, l’IA fragilise la cybersécurité de l’entreprise. Et au moindre incident, la responsabilité remonte. Toujours. Ce n’est plus une question de conformité réglementaire, mais de pilotage stratégique.

Propriété intellectuelle, RGPD, sécurité du code, confidentialité des données : chaque usage non encadré ouvre une faille potentielle. Et la vraie question n’est pas « peut-on interdire l’IA en interne ? ». Elle est devenue : « comment sécuriser son usage… sans freiner l’innovation ? »

Dans cette actualité sur l’intelligence artificielle, nous décryptons :

✅ Ce que le Shadow AI révèle de vos angles morts internes ;

✅ Comment les risques juridiques, techniques et assurantiels se croisent désormais dans chaque projet IA ;

✅ Pourquoi l’absence de cadre peut engager votre responsabilité ;

✅ Quelles bonnes pratiques mettre en place pour réconcilier performance et sécurité.

L’intelligence artificielle ne se contente pas d’accélérer vos projets. Elle peut aussi les exposer à des cyber risques dont vous porterez seul la charge.

68 %

des salariés français utilisent des outils d’intelligence artificielle sans en informer leur direction (CyberSolutions by Thales)

Shadow AI : quand vos collaborateurs exposent des données confidentielles sans le savoir

L’outil ne figure dans aucun référentiel DSI. Il n’a pas fait l’objet d’un audit de sécurité. Aucune formation interne ne le mentionne. Pourtant, il est utilisé chaque jour.

Le Shadow AI — ou usage non encadré des outils d’intelligence artificielle — s’est installé dans l’entreprise comme l’email à la fin des années 90 : sans validation, sans accompagnement et sans réelle conscience des risques. Des générateurs de texte aux assistants de code, ces technologies fondées sur l’IA s’intègrent à la routine des équipes. Dans les directions produit, les pôles marketing ou les services juridiques, les prompts deviennent des automatismes.

Et avec eux, les failles aussi.

- La part des utilisateurs de ChatGPT utilisant des comptes personnels pour leurs tâches professionnelles 73.8%

- La part des données considérées comme sensibles soumises par les employés à des outils d’IA 27.4%

Source : The AI Adoption and Risk Report – SCWorld

Le danger ne vient pas d’un bug ou d’un hacker. Il vient d’un collaborateur bien intentionné, mais mal informé. Un fichier client glissé dans un prompt pour gagner du temps. Un résumé de réunion interne soumis à un chatbot pour aller plus vite. Un code confidentiel injecté dans GitHub Copilot sans se poser la moindre question sur la réutilisation potentielle des données.

Ces gestes anodins échappent aux radars des RSSI. Ils contournent les politiques de cybersécurité classiques, car ils s’appuient sur des interfaces simples, accessibles, souvent gratuites. Et surtout, parce qu’ils ne sont pas perçus comme un usage “technique”, mais comme une aide ponctuelle à la productivité.

Le problème : aucune de ces plateformes n’offre de garantie claire sur la conservation, l’utilisation ou le recyclage des données transmises. La plupart alimentent leurs modèles avec les entrées utilisateurs. D’autres stockent les informations sur des serveurs hors UE. Et rares sont celles qui permettent une traçabilité complète des échanges.

Face à cette opacité, l’entreprise se retrouve en déséquilibre : elle ignore où partent ses données, mais reste juridiquement responsable en cas de fuite. Car selon le RGPD, c’est l’organisation qui engage sa responsabilité dès lors qu’elle traite ou expose des informations sensibles — même par l’intermédiaire d’un prestataire tiers, même via un acte isolé d’un salarié.

Le Shadow AI n’est pas un phénomène marginal. Il révèle une tension majeure : la promesse de performance immédiate face à l’absence de cadre de gouvernance. Sans encadrement, ces outils deviennent des angles morts de la cybersécurité. Et la responsabilité ne se partage pas. Elle remonte.

💡 L’essentiel à retenir

Le Shadow AI fragilise la cybersécurité de l’entreprise non pas par malveillance, mais par méconnaissance.

Chaque usage non encadré d’un outil d’intelligence artificielle peut exposer des données confidentielles sans laisser de trace visible. Et face à ces pratiques informelles, les dispositifs de cybersécurité traditionnels ne suffisent pas.

✅ Les bonnes pratiques

- Recensez les outils IA utilisés via un questionnaire interne anonyme.

- Mettez à jour votre charte informatique avec une section dédiée aux usages IA.

- Formez chaque équipe aux bons réflexes et proposez des alternatives sécurisées (ChatGPT entreprise, modèles open source hébergés).

- Ouvrez un canal interne de signalement pour les usages à risque ou non conformes.

IA et cybersécurité : qui endosse la responsabilité en cas d’incident ?

- Un modèle d’intelligence artificielle commet une erreur dans un document contractuel.

- Un assistant génératif propose une ligne de code vulnérable, injectée sans vérification.

- Un collaborateur transmet des données personnelles à un outil hébergé hors Europe.

Dans les faits, l’entreprise reste juridiquement responsable des dommages causés par un outil, même automatisé, qu’elle a laissé utiliser sans cadre ni vigilance. Les systèmes fondés sur l’IA n’ont pas d’imputabilité propre. Ils ne signent rien. Ne valident rien. Ne garantissent rien. Ce sont les utilisateurs, les services, et in fine les dirigeants, qui endossent les conséquences — fuite de données, erreur métier, faille exploitée.

Un incident lié à l’usage de l’IA soulève plusieurs niveaux de responsabilité :

- Responsabilité civile : en cas de dommage à un tiers (client, partenaire, salarié).

- Responsabilité pénale : uniquement dans certains cas, si l’entreprise ou ses dirigeants ont manifestement manqué à leur obligation de sécurité ou violé le Code pénal (divulgation de données personnelles, traitement illicite, défaut de sécurisation).

- Responsabilité managériale : si le dirigeant n’a pas mis en place de mesures de prévention documentées.

🔎 Une faille de l’intelligence artificielle peut-elle vous coûter pénalement ?

Pas automatiquement. Le non-respect du RGPD relève de sanctions administratives (CNIL), pas pénales. Mais certaines situations peuvent bel et bien engager votre responsabilité devant un tribunal :

- Fuite de données personnelles liée à un défaut manifeste de sécurité ;

- Usage d’un outil externe non audité, exposant des informations sensibles ;

- Traitement illégal de données ou négligence grave.

La ligne rouge : le manquement caractérisé à l’obligation de sécurité. Ce qui compte, c’est ce que vous avez fait — ou pas — pour anticiper le risque. Un incident isolé ne suffit pas. Mais une absence de cadre, si. Et elle se constate vite.

Ces risques ne relèvent pas de la science-fiction. L’absence de règles internes, l’usage d’outils non vérifiés ou une gestion approximative des données suffisent à créer une zone d’exposition. Et dans un environnement de plus en plus normé, toute faille non anticipée peut se transformer en faute imputable. Anticiper les failles de cybersécurité avec une couverture adaptée à votre intelligence artificielle devient essentiel pour éviter des conséquences graves et garantir la protection des données et des systèmes.

Autre difficulté : les outils utilisés appartiennent rarement à l’entreprise. Ce sont des solutions tierces, souvent américaines, avec des CGU opaques, des clauses de non-responsabilité et une gestion des litiges peu favorable aux utilisateurs européens. Résultat : en cas de contentieux, la chaîne de responsabilité remonte en interne.

💡 L’essentiel à retenir

Les outils d’IA ne sont jamais responsables. Les utilisateurs, toujours. Et derrière chaque utilisateur, l’entreprise.

En l’absence de cadre formel, chaque usage expose l’organisation — et ses dirigeants — à un risque juridique bien réel.

✅ Les bonnes pratiques

- Chaque outil tiers utilisé mérite un audit contractuel : hébergement, CGU, gouvernance des données.

- Ajoutez une clause IA dans vos contrats (clients, fournisseurs, prestataires) pour encadrer les responsabilités mutuelles.

- Assurez-vous d’avoir une couverture d’assurance adaptée : certaines polices excluent les actes liés à l’IA ou au traitement automatisé mal maîtrisé.

RGPD et IA Act : ce que la règlementation vous impose en matière de cybersécurité

Utiliser une IA sans traiter de données personnelles ? Mission impossible.

Dans les faits, toute interaction avec un modèle – entraînement, déploiement, utilisation – déclenche des obligations légales. Et pas des moindres. Le RGPD et l’IA Act règlementent les outils d’intelligence artificielle et ne laissent aucune zone grise : ils imposent un cadre clair, documenté, continu. Avec, à chaque étape, un responsable désigné. Et sans distinction entre IA maison et outil externe.

C’est bien là le piège : croire qu’en s’appuyant sur un service tiers, la responsabilité s’efface.

RGPD : qui porte la responsabilité à chaque étape de l’IA ?

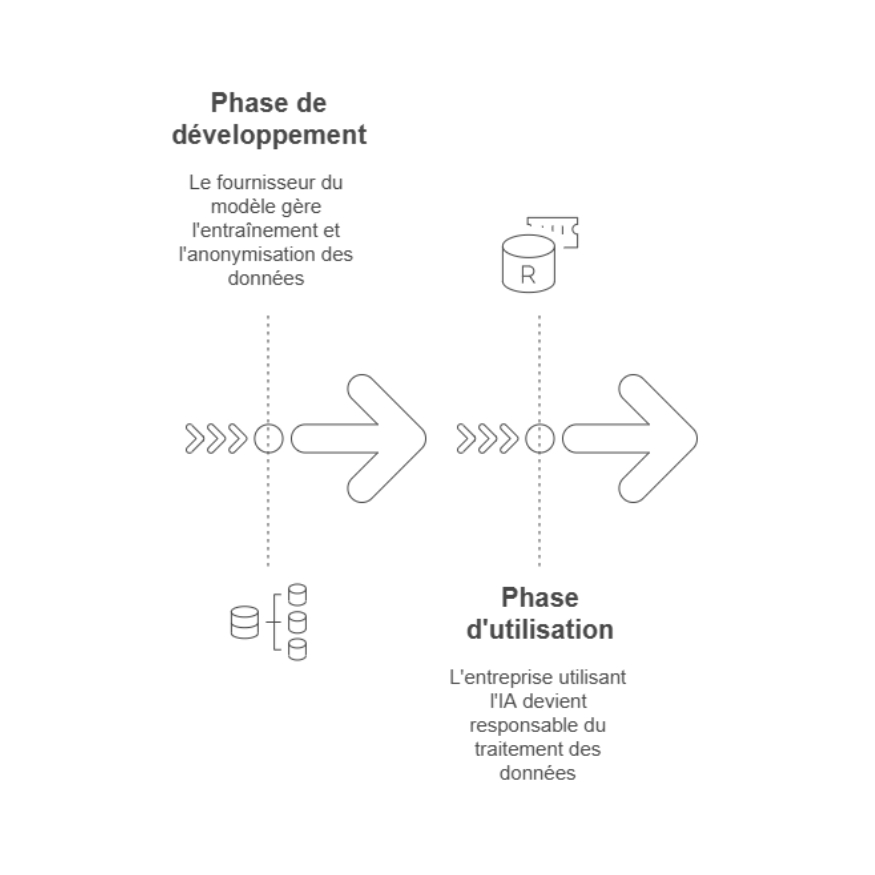

Le RGPD s’applique à chaque phase du cycle de vie d’un système d’intelligence artificielle.

- Phase de développement : le fournisseur du modèle devient responsable de traitement. Il gère l’entraînement, la collecte, la conservation, l’anonymisation. Les données utilisées doivent être exactes, pertinentes et à jour, comme le rappelle l’article 5 du RGPD. C’est sa charge et il ne peut l’éluder.

- Phase d’utilisation : l’entreprise qui utilise cette IA prend le relais. Elle devient, à son tour, responsable de traitement. Peu importe que l’outil soit signé OpenAI, Mistral ou Hugging Face. Ce qui compte : les données qu’elle injecte et ce qu’elle en fait.

À chaque usage, un engagement. À chaque donnée, une traçabilité.

⚠️ Anticipez la responsabilité avant l’incident

Même sans incident, l’absence de règles internes peut vous être reprochée. Préparez une documentation claire : outils autorisés, usages interdits, niveau de validation exigé par type de métier. Cette base ne vous protège pas de tout. Mais sans elle, vous n’avez aucun point d’appui si un incident survient.

Traçabilité, conformité, sécurité : la documentation devient un devoir réglementaire

L’IA Act ne se contente pas de classer les systèmes d’IA par niveau de risque. Il exige une documentation rigoureuse sur la gestion des données, les finalités d’usage et les garanties apportées.

Cela revient à formaliser votre gouvernance numérique :

- Quelles données sont traitées ?

- Par quel outil ?

- Pour quelle finalité ?

- Sous quelle base légale ?

- Avec quels accès, quelles protections, quels audits ?

En clair : la cybersécurité ne se résume plus à la technique. Elle devient un réflexe de conformité.

💡 L’essentiel à retenir

Le RGPD et l’IA Act imposent une chaîne de responsabilité continue.

Dès qu’une IA traite des données personnelles, votre entreprise s’engage — même si le modèle est tiers. Sans documentation, sans cartographie, sans traçabilité, votre cybersécurité ne pourra être efficace.

✅ Les bonnes pratiques

- Identifiez les données personnelles traitées, les bases légales et les finalités.

- Structurez un registre dédié aux traitements IA.

- Intégrez l’IA dans vos politiques internes de cybersécurité.

- Formez vos équipes à la notion de « responsable de traitement » dans ce contexte.

Vos questions sur la cybersécurité et l’intelligence artificielle

Quels sont les principaux risques de cybersécurité liés à l’IA ?

Les risques principaux liés à l’utilisation des modèles d’IA sont : la fuite de données sensibles, les erreurs de traitement dues à des modèles d’IA mal entraînés, la manipulation des données par des acteurs malveillants et la vulnérabilité des systèmes IA non sécurisés. En outre, les IA mal régulées peuvent être utilisées pour automatiser des attaques cyber.

Qu’est-ce que le Shadow AI et pourquoi représente-t-il un danger ?

Le Shadow AI désigne l’utilisation d’outils d’IA non validés par les départements informatiques et sécurité. Ces outils échappent au contrôle centralisé de l’entreprise, rendant difficile la traçabilité des données traitées et l’évaluation des risques. Les données sensibles peuvent ainsi être envoyées à des services non sécurisés ou stockées sans consentement explicite. Cette pratique expose l’entreprise à des violations de sécurité.

Comment sécuriser l'utilisation de l'IA face aux cyber menaces ?

Pour sécuriser l’usage de l’IA en entreprise, il est essentiel d’établir une gouvernance claire de l’usage des outils IA, d’effectuer une validation régulière des outils utilisés, d’auditer les plateformes externes et d’assurer la formation continue des équipes sur les risques et bonnes pratiques. Il est également essentiel d’intégrer des outils de cybersécurité pour détecter les anomalies et prévenir les intrusions.

Comment le RGPD et l’IA Act impactent-elles la cybersécurité de l'intelligence artificielle ?

Le RGPD impose des obligations strictes de sécurité des données traitées par des systèmes d’IA. Il exige des mesures techniques et organisationnelles pour garantir la confidentialité et l’intégrité des données personnelles.

L’IA Act, quant à lui, renforce ces exigences en définissant des normes de sécurité supplémentaires pour les IA à haut risque, avec un accent sur la traçabilité, la transparence et la documentation des processus de traitement des données. Les entreprises doivent s’assurer que chaque utilisation d’IA est conforme à ces régulations pour éviter des sanctions.