Comprendre les risques de l’intelligence artificielle pour les entreprises

L’intelligence artificielle s’invite dans les décisions stratégiques, l’automatisation des processus et la gestion des données. Derrière cette révolution, des risques concrets pour les entreprises : cyberattaques, décisions erronées, biais algorithmiques, fuites de données sensibles et incertitudes juridiques. Que votre entreprise tech développe des algorithmes ou que vos salariés utilisent des outils d’IA, identifiez les risques pour mieux les anticiper et souscrire à la bonne assurance pour l’intelligence artificielle.

Alors que plus d’une entreprise sur trois utilise déjà des systèmes d’intelligence artificielle pour automatiser des tâches complexes, quelle fiabilité accorder à ces modèles ? Qui contrôle les algorithmes ? Quelles conséquences pour les salariés et la protection des données ?

Structurer une gouvernance solide doit être votre priorité pour limiter les menaces :

- ✔ Encadrer l’usage de l’IA pour limiter les risques de fraude et d’erreurs stratégiques.

- ✔ Sécuriser les données et garantir leur conformité aux réglementations.

- ✔ Former les équipes pour une maîtrise des risques liés à l’IA.

- ✔ Souscrire à une assurance pour l’intelligence artificielle.

-

Pourquoi l'IA vous expose à de nouveaux risques ?

-

Les principaux risques pour les entreprises

-

Tableau récapitulatif de tous les risques

-

Gérer et anticiper les menaces

-

Foire aux questions

⏱️ 30 minutes pour optimiser vos garanties 🔎 Audit gratuit et sans engagement

Pourquoi l’intelligence artificielle expose-t-elle les entreprises à de nouveaux risques ?

Après une année 2024 record dans l’intégration de l’intelligence artificielle au sein des entreprises, cette accélération s’accompagne d’effets secondaires mal anticipés. Fiabilité des modèles, sécurité des données, conformité légale : chaque avancée soulève de nouveaux défis et met les organisations face à des risques qu’elles ne contrôlent pas totalement.

-

Si vous développez des modèles d’intelligence artificielle

Vous êtes responsable de leur fiabilité et de leur conformité.

-

Si vous utilisez l’IA dans votre entreprise tech

Vous devez garantir une utilisation maîtrisée et protéger vos données contre les défaillances et attaques.

Une adoption exponentielle des modèles d’IA générative aux conséquences sous-estimées

Automatisation des tâches, optimisation des processus, prise de décision assistée : l’IA s’infiltre dans chaque strate organisationnelle. 90 % des entreprises technologiques utilisent l’intelligence artificielle sous une forme ou une autre. Pourtant, combien ont réellement anticipé les risques ? Déployer une IA sans politique de gouvernance rigoureuse, c’est introduire des failles invisibles jusqu’à l’incident.

⚠️ Les risques d’une intégration sans contrôle :

- Un modèle entraîné sur des données biaisées entraine une amplification des discriminations et des erreurs.

- Une absence de contrôle humain sur certaines décisions accélère les imprécisions.

- Une dépendance aux solutions d’IA interroge sur la continuité d’activité si l’outil devient inaccessible.

L’encadrement réglementaire peine à suivre les innovations technologiques

Si l’intelligence artificielle progresse à grande vitesse, la législation et réglementation peine à suivre le mouvement. Les entreprises technologiques innovent sans cadre clair et naviguent entre opportunités et incertitudes juridiques. L’absence de règles homogènes génère des risques majeurs en matière de responsabilité et de conformité.

- Flou sur la responsabilité juridique : qui est responsable en cas d’erreur d’une IA : l’éditeur, l’entreprise utilisatrice, le développeur ?

- Conformité au RGPD et à l’AI Act : la gestion des données personnelles et transparence des décisions IA restent des sujets brûlants.

- Normes en retard : peu de standards unifiés, ce qui rend la régulation complexe pour les entreprises internationales.

📌 Le paradoxe : les entreprises veulent innover vite, mais une erreur peut entraîner des sanctions lourdes, des litiges et des crises d’image.

L’assurance notée 5⭐ sur Google

Quels sont les principaux risques de l’intelligence artificielle pour les entreprises ?

L’intelligence artificielle offre des perspectives de croissance considérables, mais son adoption exige une maîtrise rigoureuse des risques. Développer un algorithme d’apprentissage, automatiser une prise de décision ou exploiter des jeux de données sensibles implique des défis techniques, réglementaires et éthiques.

💡 Pourquoi les identifier est essentiel ?

- Anticiper les incidents pour garantir une utilisation fiable et conforme.

- Prévenir les contentieux liés aux biais algorithmiques, aux erreurs de traitement ou aux violations de données.

- Optimiser la performance et la sécurité pour protéger votre activité et votre réputation.

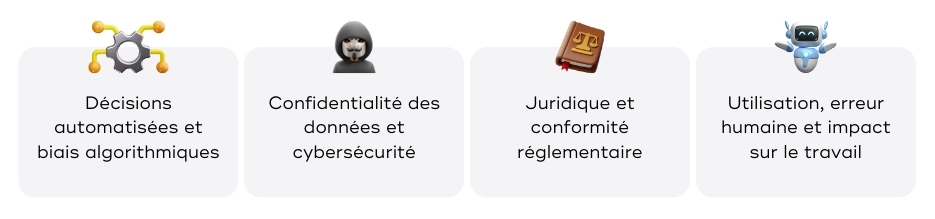

Les risques liés aux décisions automatisées et aux biais algorithmiques

- Incohérences analytiques : une IA peut fausser ses prédictions si les données d’entraînement sont biaisées.

- Fabrication d’informations fictives : certains modèles génératifs génèrent des contenus erronés sans possibilité de vérification.

- Mauvaise contextualisation des décisions : un algorithme peut ignorer des paramètres essentiels et mener votre société à des choix inadaptés.

Les risques liés à la confidentialité des données et à la cybersécurité

Les systèmes d’IA exploitent des volumes massifs de données personnelles et stratégiques. Un défaut de protection expose ces informations à des cyberattaques, des fuites de données et des abus d’utilisation.

💡 Important : tous les outils d’intelligence artificielle ne garantissent pas la suppression immédiate des données partagées. Vérifiez les CGV et paramétrez les outils pour éviter toute fuite d’informations privées.

Les risques juridiques et réglementaires

Le cadre réglementaire encadrant l’IA est en pleine évolution. La commission européenne et l’Union européenne renforcent les obligations liées à la protection des données et à la transparence des algorithmes. Ne pas se conformer à ces normes peut entraîner des sanctions financières et juridiques.

La question de la responsabilité reste floue également. En cas de litige, difficile de déterminer si la faute incombe au fournisseur de l’IA, à l’entreprise utilisatrice ou au développeur.

Les risques liés à l’utilisation par les salariés et l’impact sur le travail

Une mauvaise utilisation de l’intelligence artificielle par les salariés expose l’entreprise à des erreurs stratégiques, des fuites d’informations sensibles et des décisions incohérentes. Une confiance aveugle dans les recommandations d’un algorithme peut entraîner des prises de décision erronées, des choix discriminatoires ou une diffusion de contenus inexacts.

L’absence de cadre strict augmente aussi le risque de divulgation accidentelle de données confidentielles, notamment via des outils d’IA générative intégrés dans des échanges professionnels. Sans formation et contrôle, l’IA devient une faille exploitée, compromettant la sécurité, la conformité et la réputation de l’entreprise.

Les entreprises doivent encadrer l’automatisation pour éviter une suppression brutale de certains métiers et limiter la déshumanisation des fonctions. Si l’IA optimise des tâches, elle ne doit pas fragiliser l’organisation ni entraîner une perte de compétences essentielles. Sans équilibre entre intelligence artificielle et intervention humaine, le travail risque de devenir impersonnel et moins adapté aux besoins des équipes et des clients.

💡 Bon à savoir : même avec une charte d’utilisation stricte, un salarié peut exposer involontairement des données sensibles ou automatiser une action non conforme. Si une erreur impacte un client, un partenaire ou la conformité réglementaire, c’est l’entreprise qui porte la responsabilité. Former les équipes, définir des protocoles clairs et maintenir une supervision humaine restent essentiels pour limiter ces risques.

Tableau récapitulatif des principaux risques

| Catégorie de risque | Risque | Exemple |

|---|---|---|

| Sécurité et confidentialité | Fuite de données | Une IA mal configurée expose des informations sensibles stockées dans ses bases d’apprentissage. |

| Sécurité et confidentialité | Cyberattaques ciblant l’IA | Des attaquants exploitent des failles dans les algorithmes pour détourner des modèles et exfiltrer des données. |

| Sécurité et confidentialité | Partage non maîtrisé des données | Des connexions entre outils IA et services cloud exposent des informations confidentielles. |

| Fiabilité et exactitude des décisions | Erreurs dans les prédictions | Des décisions automatisées reposent sur des analyses biaisées et provoquent des pertes financières. |

| Fiabilité et exactitude des décisions | Hallucinations IA | Certains modèles génératifs produisent des informations incorrectes sans signaler leur incertitude. |

| Fiabilité et exactitude des décisions | Dépendance aux données d’entraînement | Un algorithme mal calibré reproduit des erreurs passées sans prise en compte du contexte actuel. |

| Conformité et réglementation | Non-respect du RGPD et de l’AI Act | L’utilisation de l’IA pour analyser des données personnelles sans consentement expose à des sanctions. |

| Conformité et réglementation | Responsabilité juridique incertaine | Une scale-up utilise un modèle IA défaillant impactant ses clients. Qui est responsable des dommages causés ? |

| Conformité et réglementation | Violation de la propriété intellectuelle | Un modèle entraîné sur des contenus protégés exploite du matériel sous copyright sans autorisation. |

| Biais et discriminations | Inégalités dans les décisions IA | Un algorithme de recrutement favorise un type de profil en raison de données biaisées. |

| Biais et discriminations | Traitement inéquitable des utilisateurs | Des IA appliquent des conditions différentes selon les catégories de clients sans justification. |

| Biais et discriminations | Fausses corrélations | Une IA relie des variables sans lien réel et fausse les résultats des analyses. |

| Opérations et continuité d’activité | Indisponibilité des outils IA | Un groupe utilisant une IA SaaS perd l’accès à ses services suite à la panne du prestataire. |

| Opérations et continuité d’activité | Défaillance des modèles en production | Un algorithme entraîné avec des données obsolètes prend des décisions inadaptées. |

| Opérations et continuité d’activité | Surcoût des ajustements | Une IA sous-performante impose des corrections fréquentes et alourdit le budget technologique. |

| Mauvaise utilisation et impact organisationnel | Décisions non supervisées par un humain | Une IA intégrée dans un processus critique prend des mesures inadaptées sans intervention manuelle. |

| Mauvaise utilisation et impact organisationnel | Mauvaise manipulation par un collaborateur | Un employé utilise un modèle IA sans comprendre ses limites et commet des erreurs graves. |

💡 Qu’est-ce qu’une attaque adversariale ?

Une attaque adversariale est une technique cherchant à tromper une intelligence artificielle en modifiant légèrement des données d’entrée (image, texte, son) pour fausser ses décisions. Elle peut être exploitée pour détourner un modèle de reconnaissance faciale, biaiser un algorithme de machine learning ou manipuler un modèle génératif.

🛡️ +500 entreprises tech innovent avec nous

Comment gérer et anticiper les risques de l’IA en entreprise ?

L’intelligence artificielle transforme les entreprises, mais son adoption expose à des risques majeurs. Une gestion efficace repose sur une gouvernance solide, des solutions techniques adaptées et une sensibilisation des équipes. Les entreprises doivent structurer un cadre de contrôle rigoureux pour éviter les décisions erronées, protéger les données et garantir la conformité réglementaire.

Mettre en place une gouvernance et des mesures de sécurité adaptées

Sans surveillance adaptée, une IA peut générer des erreurs coûteuses, faciliter des attaques malveillantes ou enfreindre des lois sur la protection des données. Pour en limiter les dérives, les entreprises doivent :

- Établir une gouvernance : définir des règles sur son champ d’application, les responsabilités associées et les limites d’automatisation.

- Auditer les modèles en continu : tester leur robustesse, identifier les biais algorithmiques et s’assurer qu’ils respectent les normes en vigueur.

- Sécuriser les systèmes : crypter les données, verrouiller les accès aux algorithmes et surveiller les interactions avec des services tiers.

- Former les collaborateurs : éviter qu’un employé alimente une IA avec des informations confidentielles ou interprète mal une recommandation automatisée.

Un encadrement rigoureux réduit les failles et protège l’entreprise contre les risques opérationnels et juridiques.

Le rôle de l’assurance dans la gestion des risques de l’intelligence artificielle

Même avec des protocoles stricts, aucun modèle n’est infaillible. Une assurance spécialisée doit obligatoirement couvrir plusieurs aspects :

- Responsabilité civile professionnelle en cas de dommages causés par votre intelligence artificielle

- RC Cyber et Cyber dommages pour couvrir les conséquences d’une cyberattaque visant votre modèle et impactant vos clients comme votre startup.

Ces deux garanties doivent explicitement couvrir tous les risques du développement ou de l’utilisation des modèles génératifs et intelligents.

📞 Votre expert en direct par email, téléphone ou visio

Risques et menaces de l’IA sur les entreprises tech : nos réponses à vos questions

Vous ne trouvez pas votre réponse ? Appelez-nous ou prenez RDV en ligne.

Quelles sont les principales menaces de l’intelligence artificielle pour une entreprise technologique ?

L’IA expose les organisations à des périls liés à la cybersécurité, à la fiabilité des décisions, aux biais algorithmiques, à la violation de la confidentialité et aux incertitudes réglementaires.

Pourquoi les algorithmes d’intelligence artificielle présentent-ils des vulnérabilités ?

Les modèles IA sont sensibles aux erreurs d’entraînement, aux manipulations adversariales et aux biais intrinsèques des données, ce qui peut fausser leurs résultats et compromettre leur fiabilité.

Quels risques juridiques une entreprise encourt-elle en cas de mauvaise utilisation de l’IA ?

Une organisation qui intègre un modèle IA non conforme aux régulations peut être sanctionnée pour non-respect du RGPD, défaut de transparence ou discrimination algorithmique.

Comment limiter les risques de l'intelligence artificielle ?

La mise en place de protocoles stricts de protection des données, des audits réguliers et une supervision humaine permettent de limiter les atteintes à la confidentialité et aux infrastructures sensibles. Une assurance dédiée à l’intelligence artificielle permet de couvrir les différents impacts et conséquences.