Réglementation de l’intelligence artificielle : IA Act, RGPD et obligations légales

Que vous développiez une solution d’intelligence artificielle ou que vous l’intégriez dans vos processus métier, votre entreprise est directement concernée. Algorithmes prédictifs, modèles génératifs, automatisation des décisions : les usages se multiplient, mais avec eux émergent de nouveaux risques légaux et réglementaires. Éclairage sur la conformité et l’assurance de l’IA.

L’essentiel à retenir sur la conformité et la régulation de l’intelligence artificielle

Le cadre juridique de l’intelligence artificielle en Europe se renforce, avec notamment :

- ✔ L’IA Act, la première régulation européenne classant les systèmes IA selon leur niveau de risque.

- ✔ Le RGPD, qui impose une gouvernance stricte des données personnelles utilisées par les modèles IA.

- ✔ Les obligations légales des entreprises, notamment en matière de transparence et de responsabilité.

Ne pas anticiper ces réglementations expose à des sanctions financières importantes, des restrictions d’usage, voire une mise en cause juridique en cas de préjudice causé par l’intelligence artificielle.

Comment se conformer aux nouvelles règles ? Quelles actions mettre en place dès maintenant ? Ce guide vous apporte toutes les réponses pour aligner vos pratiques à la conformité et protéger votre entreprise.

-

L'IA Act : cadre juridique et sanctions

-

Obligations et protection des données du RGPD

-

Quelle responsabilité légale des entreprises

-

Comment vous protège l'assurance

-

Foire aux questions

⏱️ 30 minutes pour optimiser vos garanties 🔎 Audit gratuit et sans engagement

L’IA Act : le premier cadre juridique européen sur l’intelligence artificielle

L’IA Act est la première régulation européenne conçue spécifiquement pour encadrer l’intelligence artificielle et ses usages. Entré en vigueur en août 2024, ce texte vise à assurer la transparence, la sécurité et la fiabilité des systèmes d’IA utilisés en Europe.

Face à l’essor des modèles d’apprentissage automatique, des IA génératives et des systèmes autonomes, ce cadre légal impose de nouvelles obligations aux entreprises développant ou exploitant ces technologies.

Quels sont les objectifs de l’IA Act ?

L’IA Act repose sur trois principes fondamentaux :

- Protéger les droits fondamentaux des citoyens européens face aux décisions automatisées.

- Encadrer l’usage des IA à risque élevé, notamment dans les secteurs critiques (santé, finance, justice, surveillance).

- Prévenir les dérives liées aux biais algorithmiques, à la désinformation et aux atteintes à la vie privée.

Concrètement, cette loi impose des exigences strictes en matière de transparence, de gouvernance des données et d’évaluation des risques pour les entreprises exploitant des modèles d’intelligence artificielle.

Classification du règlement : votre modèle est-il concerné ?

L’IA Act classe les systèmes d’intelligence artificielle en quatre catégories de risque, chacune soumise à des obligations spécifiques. Pour les entreprises manipulant des données sensibles ou automatisant des décisions critiques, la mise en place de garanties adaptées aux risques cyber liés à l’IA est essentielle pour se prémunir contre les sanctions et violations réglementaires.

| Catégorie de risque | Exemples de technologies concernées | Vos obligations |

|---|---|---|

| Risque inacceptable | Reconnaissance faciale en temps réel, manipulation cognitive, systèmes de notation sociale | Interdiction totale en Europe |

| Risque élevé | IA en santé, recrutement, scoring financier, justice | Audit de conformité, transparence renforcée, documentation obligatoire |

| Risque limité | Chatbots IA, assistants virtuels, outils d’aide à la rédaction | Obligation d’information et transparence sur l’usage de l’IA |

| Risque minimal | IA utilisée dans les jeux vidéo, outils de productivité, filtres d’image | Aucune obligation spécifique |

📌 Votre entreprise développe ou exploite une IA ?

Si votre modèle entre dans la catégorie à risque élevé, vous devrez mettre en place des mesures de conformité strictes :

- Évaluer et documenter les risques de votre IA ;

- Garantir la transparence et l’auditabilité des décisions automatisées ;

- Mettre en place une gouvernance des données robuste.

Quelles sanctions en cas de non-conformité à l’IA Act ?

Le non-respect de l’IA Act expose les entreprises à des sanctions financières sévères.

| Infractions et violations | Montant des sanctions |

|---|---|

| Infractions les plus graves (exploitation de systèmes interdits, non-respect des exigences réglementaires) | Jusqu’à 30 millions d’euros ou 6 % du chiffre d’affaires mondial |

| Non-respect des obligations de transparence et d’évaluation des risques | Jusqu’à 20 millions d’euros ou 4 % du chiffre d’affaires mondial |

| Violations administratives ou techniques | Jusqu’à 10 millions d’euros ou 2 % du chiffre d’affaires mondial |

⚠️ Les entreprises concernées doivent donc dès maintenant anticiper leur mise en conformité pour éviter toute sanction et assurer la pérennité de leurs solutions d’intelligence artificielle. Retrouvez le calendrier de mise en œuvre.

L’assurance notée 5⭐ sur Google

RGPD et intelligence artificielle : quelles obligations pour la gestion des données ?

Le RGPD (Règlement Général sur la Protection des Données) est un pilier incontournable de la réglementation européenne en matière de protection des données personnelles. Depuis son entrée en vigueur en 2018, ce cadre législatif impose aux entreprises exploitant des modèles d’intelligence artificielle, des systèmes d’apprentissage automatique ou des solutions d’analyse prédictive de respecter des règles strictes en matière de transparence et de sécurité.

Face à la montée en puissance des modèles génératifs, IA conversationnelles et des Large Language Models (LLM), le RGPD encadre désormais plus spécifiquement l’usage des données personnelles dans l’IA, avec des obligations renforcées pour les entreprises exploitant ces technologies. Pour les acteurs du numérique, cela implique également de repenser la manière dont leurs contrats d’assurance prennent en charge ces nouvelles exigences et couvrent les responsabilités associées. C’est un enjeu clé pour les éditeurs de logiciels intégrant l’intelligence artificielle, dont les produits sont directement soumis à ces obligations réglementaires.

Quelles sont les règles à respecter pour une bonne gouvernance des données ?

Les modèles d’intelligence artificielle traitent des volumes massifs de données, souvent issues de bases d’informations sensibles. Cela pose plusieurs enjeux majeurs :

Le RGPD impose trois principes fondamentaux aux entreprises utilisant l’IA :

- Minimisation des données : ne collecter que les informations strictement nécessaires à l’entraînement des modèles.

- Transparence et explicabilité : informer clairement les utilisateurs sur l’usage des données par l’algorithme.

- Droit des personnes : garantir aux individus le droit d’accès, de rectification et de suppression de leurs informations personnelles.

💡 Un chatbot d’assistance juridique basé sur un modèle de traitement automatique du langage naturel (NLP) doit informer les utilisateurs sur la manière dont leurs échanges sont collectés et stockés.

Consentement, transparence et droits des utilisateurs : ce que dit le RGPD

Toute entreprise utilisant une IA qui collecte ou exploite des informations personnelles doit mettre en place des mécanismes de conformité stricts :

- Obligation de consentement : l’utilisateur doit être informé clairement et explicitement de l’usage de ses données.

- Obligation de traçabilité : l’entreprise doit documenter comment et pourquoi les données sont utilisées.

- Obligation d’auditabilité : l’IA doit être capable d’expliquer les décisions prises, notamment pour éviter les biais et discriminations.

Sanctions en cas de non-respect : les entreprises ne respectant pas ces obligations s’exposent à des amendes pouvant atteindre 20 millions d’euros ou 4 % de leur chiffre d’affaires mondial.

💡 Une entreprise développant un modèle de scoring financier doit s’assurer que les individus puissent comprendre pourquoi un prêt leur a été refusé.

Comment sécuriser la collecte et le traitement des données ?

Les bonnes pratiques pour une intelligence artificielle conforme au RGPD :

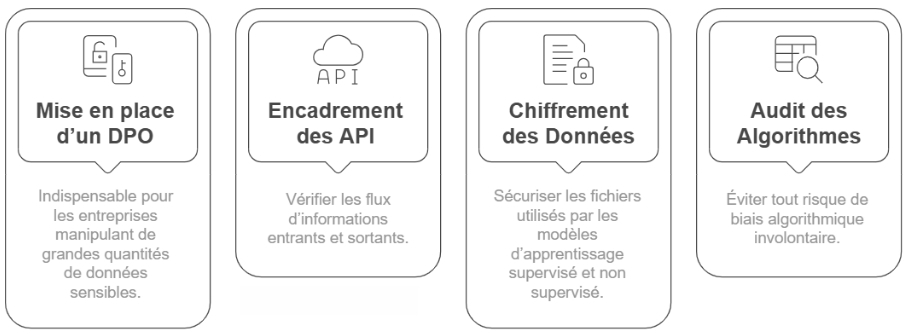

- Mise en place d’un DPO (Délégué à la Protection des Données) : indispensable pour les entreprises manipulant de grandes quantités de données sensibles.

- Encadrement des API IA connectées à des bases de données personnelles : vérifier les flux d’informations entrants et sortants.

- Chiffrement et anonymisation des données : sécuriser les fichiers utilisés par les modèles d’apprentissage supervisé et non supervisé.

- Audit régulier des algorithmes et des jeux de données : éviter tout risque de biais algorithmique involontaire.

💡 Une startup développant une IA de reconnaissance faciale doit garantir que les images utilisées pour entraîner son algorithme respectent le principe de minimisation des données et ne soient pas stockées indéfiniment.

Les obligations légales et la responsabilité des entreprises

L’essor de l’intelligence artificielle dans des secteurs critiques (finance, santé, ressources humaines) impose aux entreprises des obligations légales strictes. Toute décision prise par un modèle d’IA doit être transparente, explicable et auditable. En première ligne, les ESN et SSII doivent sécuriser leur responsabilité professionnelle face aux risques liés à l’usage de l’intelligence artificielle dans leurs missions.

Qui est juridiquement responsable en cas d’incident ?

Les entreprises qui développent ou exploitent une intelligence artificielle doivent anticiper leur responsabilité légale en cas d’incident.

| Le développeur de l’IA | Si le modèle présente un biais algorithmique entraînant une discrimination ou un préjudice économique |

| L’entreprise utilisatrice | Si un outil de décision automatisé cause une erreur impactant un client ou un salarié. |

| Le fournisseur de données | Si les datasets utilisés pour entraîner l’IA contiennent des informations biaisées ou inexactes. |

⚖️ Ce que dit la législation française sur la responsabilité

1. Responsabilité du fait des choses

Selon l’article 1242 du Code civil, une entreprise peut être tenue responsable si son IA cause un dommage. Cependant, prouver qu’un algorithme est « anormal » ou identifier son défaut reste complexe.

2. Responsabilité pour faute

L’article 1240 du Code civil impose de prouver une faute, un préjudice et un lien de causalité. Avec l’IA, la multiplicité des acteurs (développeurs, fournisseurs, utilisateurs) complique l’attribution des responsabilités.

3. Responsabilité du fait des produits défectueux

La directive européenne 85/374/CEE engage la responsabilité des producteurs si un produit IA défectueux cause un dommage. Identifier si le problème vient du matériel, du logiciel ou des données utilisées est un enjeu clé.

En l’absence de jurisprudence claire, les entreprises doivent renforcer la traçabilité et la gouvernance de leurs systèmes d’IA pour limiter les risques juridiques.

Comment réduire les risques juridiques ?

Pour réduire le risque juridique, 3 bonnes pratiques à respecter :

- Documenter et auditer vos modèles pour garantir l’explicabilité.

- Mettre en place un comité de gouvernance IA et des audits réguliers.

- Garantir aux utilisateurs un droit de recours en cas de décision automatisée injustifiée.

En cas de litige, l’entreprise exploitant l’intelligence artificielle est légalement responsable et doit prouver sa conformité.

🛡️ +500 entreprises tech innovent avec nous

Conformité et assurance : quelle relation pour protéger votre entreprise ?

Il est essentiel de préciser que l’assurance ne couvre pas automatiquement les sanctions administratives. Pour notre contrat Tech360, il est spécifiquement mentionné que l’assurance prendra en charge les charges financières des sanctions pécuniaires administratives prononcées par des autorités publiques (dommages-intérêts compensatoires et réglementaires, amendes administratives ou sanctions) mais uniquement dans la mesure où leur assurabilité est permise par la loi.

🛑 Inassurabilité des sanctions pénales : les amendes prononcées par une juridiction pénale ne peuvent être prises en charge par une assurance, car il est interdit d’indemniser les dettes pénales. Cette interdiction est d’ordre public et vise à garantir que les sanctions conservent leur effet dissuasif.

🛑 Extension aux sanctions administratives : Bien que les sanctions administratives ne soient pas explicitement mentionnées, la jurisprudence et la doctrine concluent traditionnellement à leur inassurabilité, surtout lorsqu’elles revêtent un caractère pénal ou quasi pénal. Cette position est fondée sur le même principe d’ordre public.

Toutefois, en cas de non-respect des exigences de l’IA Act ou du RGPD, la souscription à une assurance dédiée à votre intelligence artificielle est essentielle pour limiter l’impact financier. Notre assurance Tech360 prend en charge :

- Frais de défense en cas de mise en cause (non-respect du RGPD, non-conformité IA Act).

- Indemnisation des tiers en cas de litige (ex : préjudice causé par une décision automatisée).

- Protection en cas de violation de données : prise en charge des coûts liés à une cyberattaque exposant les données confidentielles de votre entreprise technologique et/ou de vos clients.

- Assistance en gestion de crise : experts cyber et juridiques en cas d’incident impactant votre conformité IA.

📞 Votre expert en direct par email, téléphone ou visio

FAQ sur la conformité de l’intelligence artificielle (IA Act et RGPD)

Vous ne trouvez pas votre réponse ? Appelez-nous ou prenez RDV en ligne.

Mon entreprise développe une intelligence artificielle, quelles sont mes obligations légales ?

Vous devez garantir la transparence, la sécurité et la conformité de votre modèle IA. Selon l’IA Act et le RGPD, cela implique :

- Documenter les risques et biais éventuels.

- Gérer les données personnelles de façon sécurisée (minimisation, consentement, droit d’accès).

- Garantir l’explicabilité des décisions automatisées pour éviter toute discrimination.

Quels sont les risques si mon entreprise ne respecte pas l’IA Act ?

Le non-respect de l’IA Act peut entraîner des amendes allant jusqu’à 30 millions d’euros ou 6 % du chiffre d’affaires mondial. En plus des sanctions financières, votre IA peut être interdite d’exploitation en Europe si elle est classée à risque élevé sans conformité.

L’assurance peut-elle couvrir les sanctions RGPD ou IA Act ?

Non, les sanctions administratives et amendes ne sont pas couvertes par une assurance. En revanche, une assurance comme Tech360 prend en charge :

- Les frais de défense en cas de litige lié à la non-conformité.

- L’indemnisation des tiers.

- L’accompagnement en gestion de crise (cyberattaque, fuite de données, enquête de régulateur).